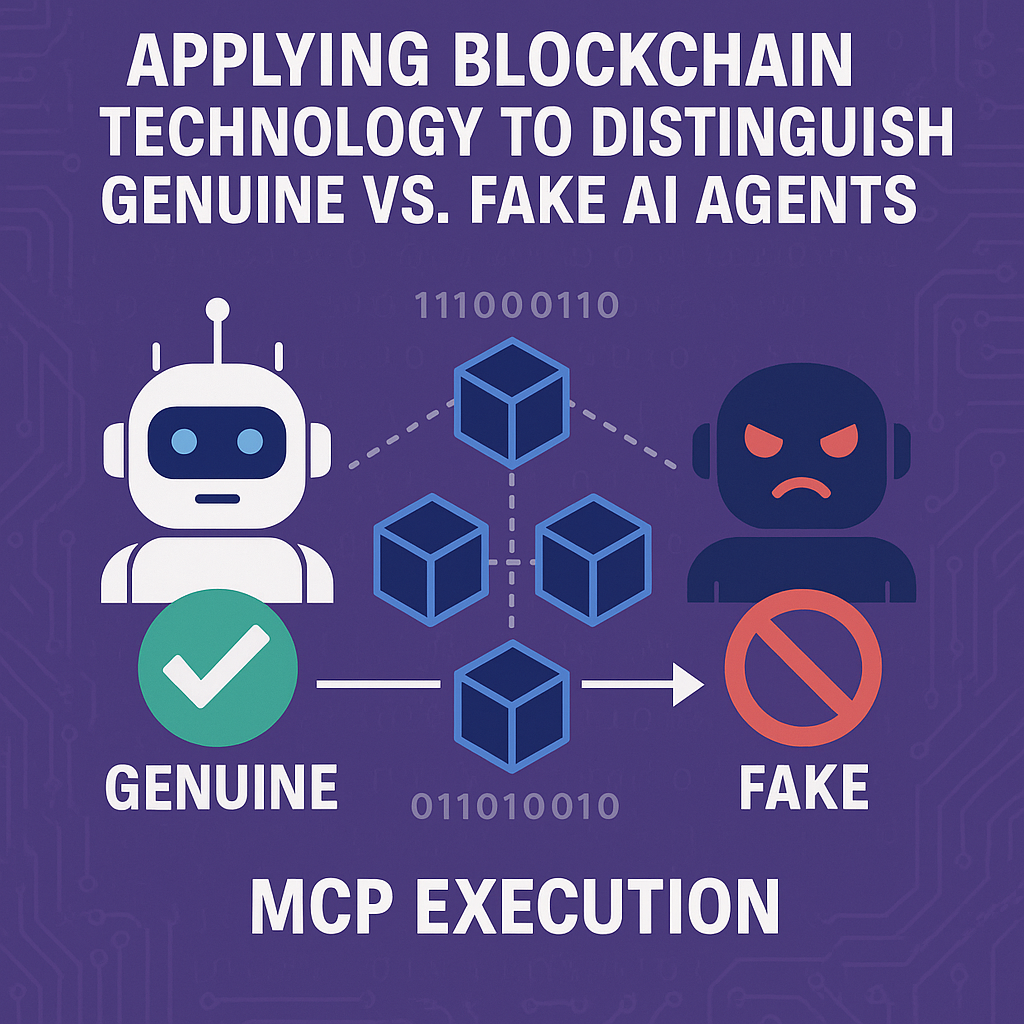

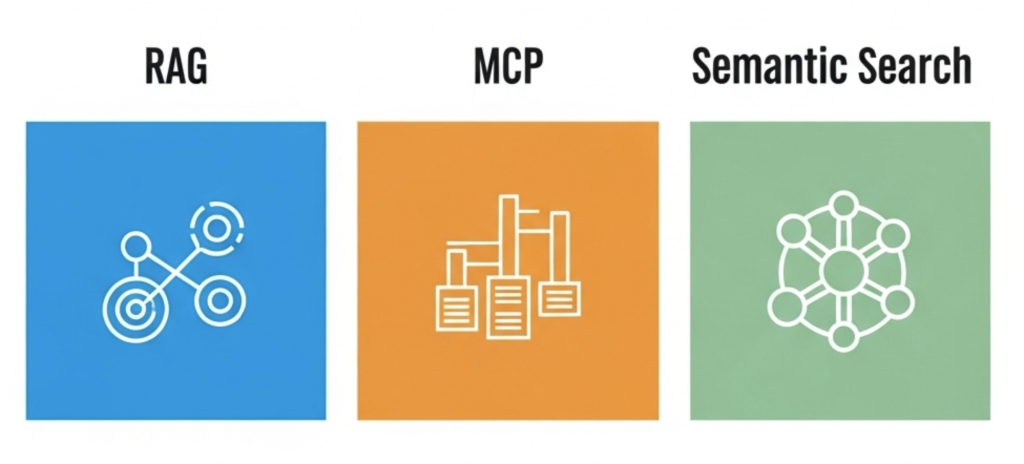

Die Erstellung der perfekten Einkaufsliste bei Shopify beginnt oft damit, wie wir den Text eines Benutzers interpretieren. Während beide Ansätze darauf abzielen, relevante Ergebnisse zu liefern, nähern sich die zugrunde liegenden Methoden von MCP (Maximum Common Subsequence) und RAG (Retrieval-Augmented Generation) dieser Aufgabe mit grundlegend unterschiedlichen Philosophien. Das Verständnis dieser Unterschiede ist entscheidend, um intelligentere und intuitivere E-Commerce-Erlebnisse zu schaffen.

Der MCP-Ansatz: Stichwortabgleich

Die MCP-Methode konzentriert sich auf den direkten Textabgleich. Wenn ein Benutzer etwas wie “rotes T-Shirt” eingibt, durchsucht das System Produktnamen, Beschreibungen und Tags innerhalb von Shopify, um Instanzen von “rot” und “T-Shirt” zu finden. Es handelt sich im Wesentlichen um eine stichwortbasierte Suche, bei der das genaue Vorhandensein von Wörtern oder Phrasen Priorität hat.

So funktioniert es für Einkaufslisten:

- Wörtlicher Abgleich: Das System sucht nach exakten Stichwortübereinstimmungen. Wenn Sie nach “rotem T-Shirt” suchen, sucht es nach Produkten, die explizit sowohl “rot” als auch “T-Shirt” enthalten.

- Begrenztes semantisches Verständnis: Diese Methode hat Schwierigkeiten mit Nuancen. Sie wird nicht von Natur aus verstehen, dass “warme Jacke” auch eine “Wolljacke” bedeuten könnte, wenn das Wort “warm” in der Produktbeschreibung nicht vorhanden ist.

- Effizienz bei spezifischen Anfragen: Für Benutzer, die genau wissen, wonach sie suchen und klare Stichwörter verwenden, kann MCP recht effizient und einfach zu implementieren sein.

Einschränkungen:

- Schlechtes Verständnis der Absicht: Es hat Schwierigkeiten, komplexe oder vage Benutzerabsichten zu erfassen. Eine Anfrage wie “Ideen für Geburtstagsgeschenke” liefert keine sinnvollen Ergebnisse.

- Probleme mit Synonymen: Es kann Synonyme wie “Sneaker” und “Sportschuhe” nicht einfach verarbeiten, wenn sie nicht explizit verknüpft sind.

- Mangelnder Kontext: Es berücksichtigt weder die Benutzerhistorie, Präferenzen noch den breiteren Einkaufskontext.

- Recall-Probleme: Hochrelevante Produkte könnten übersehen werden, wenn sie nicht die genauen Stichwörter enthalten, die der Benutzer eingegeben hat.

Der RAG-Ansatz: Semantisches Verständnis und KI-Generierung

RAG oder Retrieval-Augmented Generation stellt einen bedeutenden Fortschritt dar. Es kombiniert die Leistungsfähigkeit der semantischen Suche mit den generativen Fähigkeiten großer Sprachmodelle (LLMs). Anstatt nur Stichwörter abzugleichen, zielt RAG darauf ab, die Bedeutung hinter der Benutzeranfrage zu verstehen und eine umfassende Antwort zu generieren.

So funktioniert es für Einkaufslisten:

- Vektor-Embeddings: Alle Shopify-Produktinformationen (Namen, Beschreibungen, Bilder, Rezensionen) werden in hochdimensionale numerische Darstellungen, sogenannte Vektoren, umgewandelt. Ähnliche Produkte haben Vektoren, die in diesem mehrdimensionalen Raum “nah” beieinander liegen und ihre semantischen Beziehungen erfassen. Diese Vektoren werden in einer Vektordatenbank gespeichert.

- Semantische Suche: Wenn ein Benutzer “rotes T-Shirt” eingibt, wird seine Anfrage ebenfalls in einen Vektor umgewandelt. Das System führt dann eine semantische Suche in der Vektordatenbank durch, um Produkte zu finden, deren Vektoren dem Vektor der Benutzeranfrage am ähnlichsten sind, unabhängig von exakten Stichwortübereinstimmungen. Das bedeutet, wenn Sie nach “warmer Jacke” suchen, könnte es intelligent “Wolljacken” oder “Daunenjacken” finden, auch wenn sie das Wort “warm” nicht explizit verwenden.

- LLM-Erweiterung: Die relevantesten abgerufenen Produktinformationen werden dann an ein LLM weitergeleitet. Das LLM verwendet diese Informationen, um eine umfassende Einkaufsliste zu generieren, die nicht nur Produktnamen, sondern auch kurze Beschreibungen, Empfehlungsgründe und sogar Vergleiche bietet.

- Tiefes Verständnis der Absicht: RAG kann komplexe natürliche Sprachanfragen wie “Empfehlen Sie eine lässige Tasche als Geburtstagsgeschenk für eine 20-jährige Frau” verarbeiten. Es versteht die Nuancen und den Kontext solcher Anfragen.

Vorteile:

- Anspruchsvolle Absichtserkennung: RAG zeichnet sich dadurch aus, dass es die tiefere Bedeutung und Absicht hinter Benutzeranfragen versteht und über den einfachen Stichwortabgleich hinausgeht.

- Personalisiertes Einkaufen: Durch die Integration der Benutzerhistorie und Präferenzen in die Vektordatenbank kann RAG hochgradig personalisierte Produktempfehlungen liefern.

- Umfassende Informationsgenerierung: Es kann detaillierte und hilfreiche Informationen über Produkte, Zusammenfassungen, Vergleiche und Kaufüberlegungen generieren, was das gesamte Einkaufserlebnis verbessert.

- Hoher Recall: Es ist wahrscheinlicher, relevante Produkte auch bei unterschiedlichen Formulierungen oder mehrdeutigen Anfragen zu finden.

- Aktuelle Informationen: Vektordatenbanken können kontinuierlich aktualisiert werden, sodass das LLM auf die neuesten Produktinformationen zugreifen kann.

Komplexität:

- Höherer Implementierungsaufwand: Der Aufbau und die Pflege von Vektordatenbanken, Embedding-Modellen und die Integration mit LLMs ist erheblich komplexer und ressourcenintensiver.

- Kosten: Es können Kosten für LLM-APIs und die Verwaltung von Vektordatenbanken anfallen.

- Potenzial für Halluzinationen (abgemildert): Obwohl RAG dazu beiträgt, sie zu reduzieren, können LLMs manchmal Informationen generieren, die nicht ganz korrekt sind, obwohl dies bei gut konzipierten RAG-Systemen seltener vorkommt.

Zusammenfassend lässt sich sagen, dass der MCP-Ansatz eine einfache, stichwortbasierte Suche bietet, die sich ideal für direkte Anfragen eignet, während der RAG-Ansatz ein intelligenteres, kontextsensitiveres und personalisierteres Einkaufserlebnis bietet, indem er die Nuancen der Sprache versteht und leistungsstarke KI-Modelle nutzt. Für den modernen E-Commerce, der die Benutzerbindung und die Empfehlungsgenauigkeit verbessern möchte, stellt RAG die Zukunft der Einkaufslistengenerierung dar.